专题:DeepSeek为何能回荡寰球AI圈

起头:新智元

这些天,硅谷透彻处于中国公司带来的地面震余波中。

全好意思都在浮躁:是否寰球东说念主工智能的中心照旧回荡到了中国?

就在这当口,寰球复现DeepSeek的一波怒潮也来了。

诚如LeCun所言:‘这一次,恰是开源对闭源的告捷!’

万般这些不雅点和盘问,让东说念主不禁怀疑:数百亿好意思元支拨,对这个行业真的必要吗?致使有东说念主说,中国量化基金的一群天才,将导致纳斯达克崩盘。

从此,大模子时期很可能会参加一个分水岭:超强性能的模子不再独属于算力巨头,而是属于每个东说念主。

30好意思金,就能看到‘啊哈’时刻

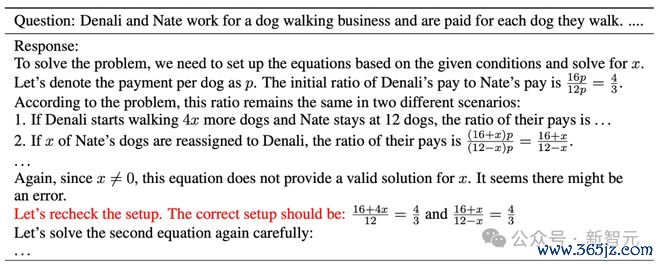

来自UC伯克利博士生潘家怡和另两位考虑东说念主员,在CountDown游戏中复现了DeepSeek R1-Zero。

他们暗示,限度相当出色!

现实中,团队考据了通过强化学习RL,3B的基础说话模子也能够自我考据和搜索。

更令东说念主应允的是,资本不到30好意思金(约217元),就可以亲眼见证‘啊哈’时刻。

这个口头叫作念TinyZero,招揽了R1-Zero算法——给定一个基础说话模子、教导和确切奖励信号,运行强化学习。

然后,团队将其诈欺在CountDown游戏中(这是一个玩家使用基础算术运算,将数字组合以达到筹商数字的游戏)。

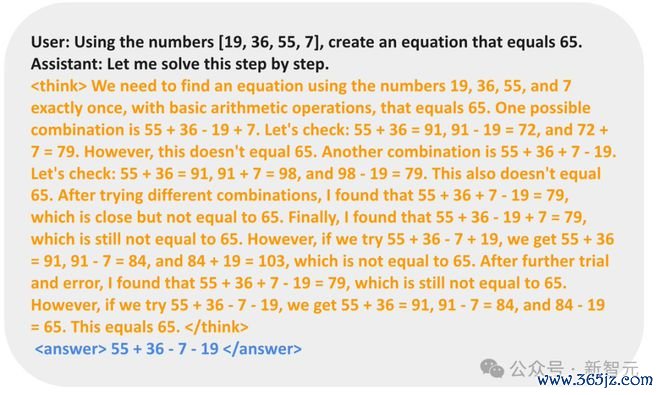

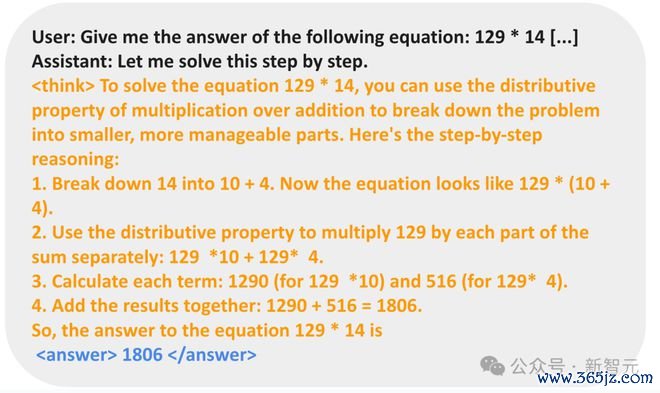

模子从最初的简短输出脱手,冷静进化出自我篡改和搜索的战略。

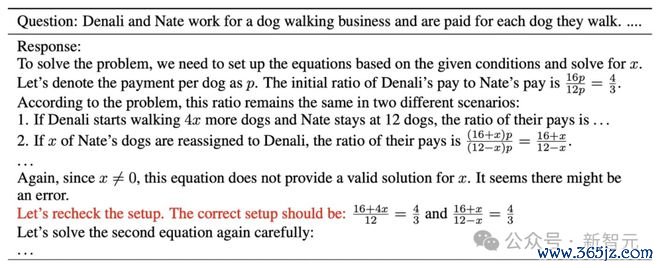

在以下示例中,模子提议了惩办决策,自我考据,并反复篡改,直到惩办问题为止。

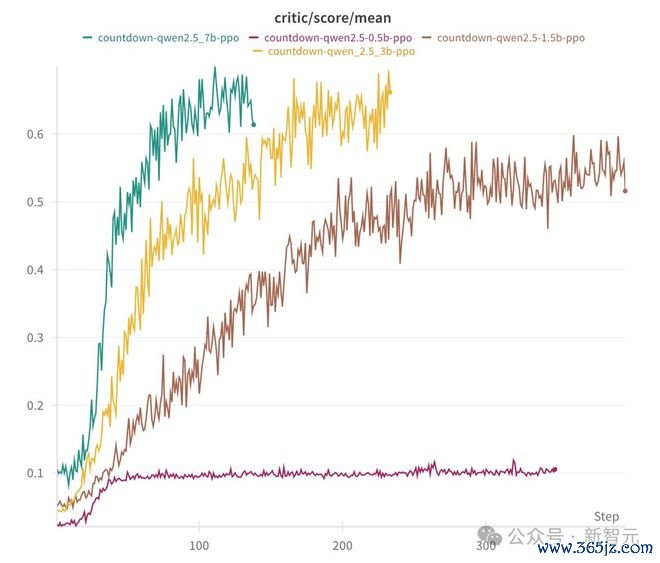

在消融现实中,考虑东说念主员运行了Qwen-2.5-Base(0.5B、1.5B、3B、7B四种参数边界)。

限度发现,0.5B模子只是是估计一个惩办决策然后住手。而从1.5B脱手,模子学会了搜索、自我考据和修正其惩办决策,从而能够取得更高的分数。

他们觉得,在这个经过,基础模子的是性能的关节。

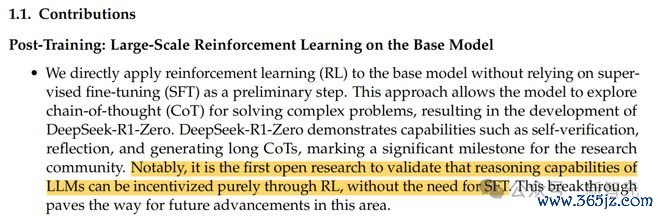

他们还考据了,非凡的指示微调(SFT)并非是必要的,这也印证了R1-Zero的联想决策。

这是首个考据LLM推理能力的竣事可以纯正通过RL,无需监督微调的开源考虑

基础模子和指示模子两者区别:

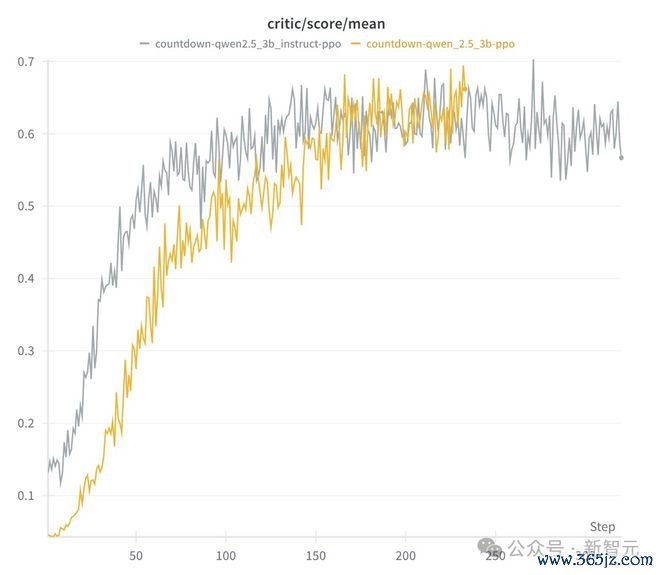

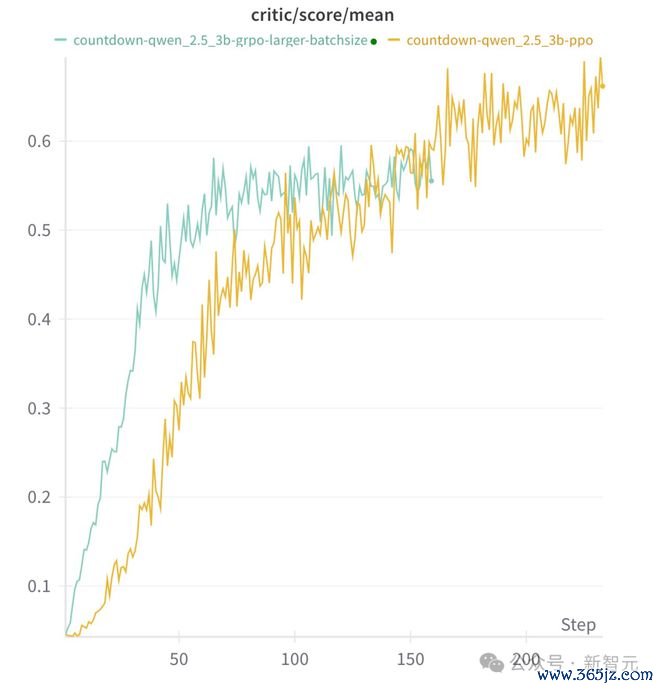

此外,他们还发现,具体的RL算法并不进击。PPO、GRPO、PRIME这些算法中,长念念维链(Long CoT)都能够露出,且带来可以的性能阐扬。

而且,模子在推理行为中极度依赖于具体的任务:

苹果机器学习科学家Yizhe Zhang对此暗示,太酷了,小到1.5B的模子,也能通过RL露出出自我考据的能力。

7B模子复刻,限度令东说念主讶异

港科大助理老师何俊贤的团队(共并吞作黄裕振、Weihao Zeng),只用了8K个样本,就在7B模子上复刻出了DeepSeek-R1-Zero和DeepSeek-R1的西席。

限度令东说念主惊喜——模子在复杂的数学推理上取得了十分强盛限度。

口头地址:https://github.com/hkust-nlp/simpleRL-reason

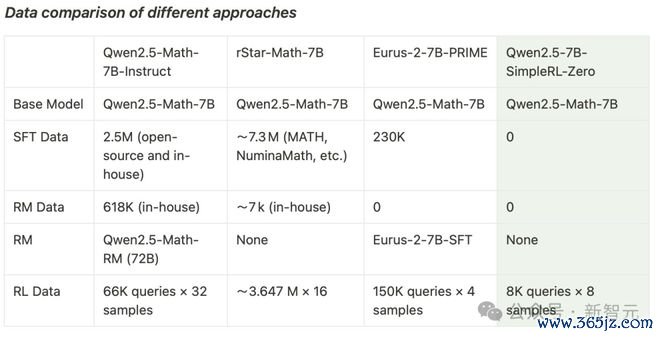

他们以Qwen2.5-Math-7B(基础模子)为起始,平直对其进行强化学习。

统统经过中,莫得进行监督微调(SFT),也莫得使用奖励模子。

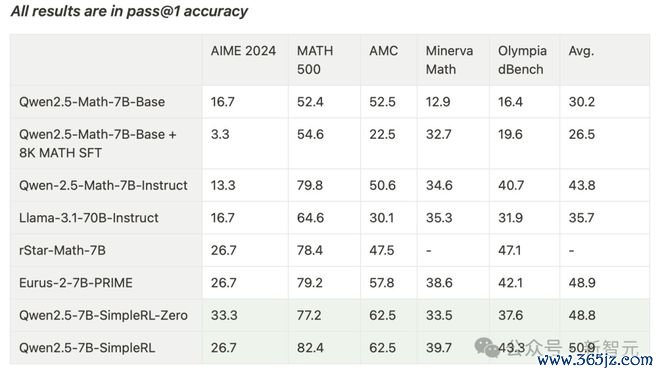

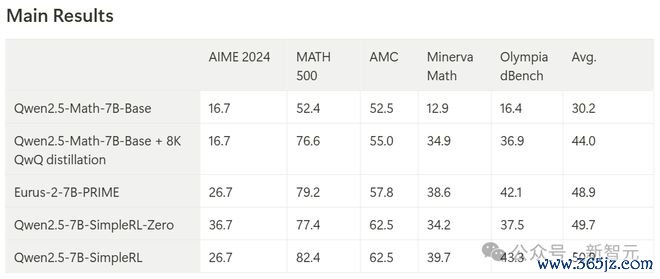

最终,模子在AIME基准上竣事了33.3%的准确率,在AMC上为62.5%,在MATH上为77.2%。

这一阐扬不仅杰出了Qwen2.5-Math-7B-Instruct,况且还可以和使用起先50倍数据量和更复杂组件的PRIME和rStar-MATH相失色!

其中,Qwen2.5-7B-SimpleRL-Zero是在Qwen2.5-Math-7B基础模子上仅使用纯PPO步调西席的,仅招揽了MATH数据都集的8K样本。

Qwen2.5-7B-SimpleRL则起先通过Long CoT监督微调(SFT)当作冷启动,然后再进行强化学习。

在这两种步调中,团队都只使用了换取的8K MATH样本,仅此费力。

能够在第44步的时间,‘啊哈时刻’出现了!模子的反应中,出现了自我反念念。

况且,在这个经过中,模子还披露了更长的CoT推理能力和自我反念念能力。

在博客中,考虑者详备理会了现实开荒,以及在这个强化学习西席经过中所不雅察到的气候,举例长链式念念考(CoT)和自我反念念机制的自愿酿成。

与DeepSeek R1访佛,考虑者的强化学习决策极其简短,莫得使用奖励模子或MCTS(蒙特卡洛树搜索)类本事。

他们使用的是PPO算法,并招揽基于法例的奖励函数,凭据生成输出的口头和正确性分派奖励:

该竣事基于OpenRLHF。初步磨砺标明,这个奖励函数有助于战略模子快速拘谨,产生顺应盼望口头的输出。

第一部分:SimpleRL-Zero(重新脱手的强化学习)

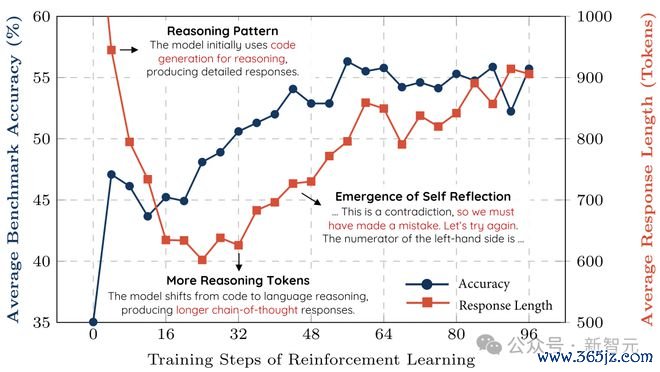

接下来,考虑者为咱们共享了西席经过动态分析和一些道理的露出模式。

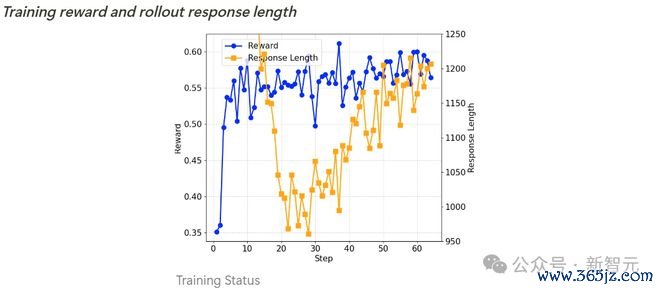

西席经过动态分析

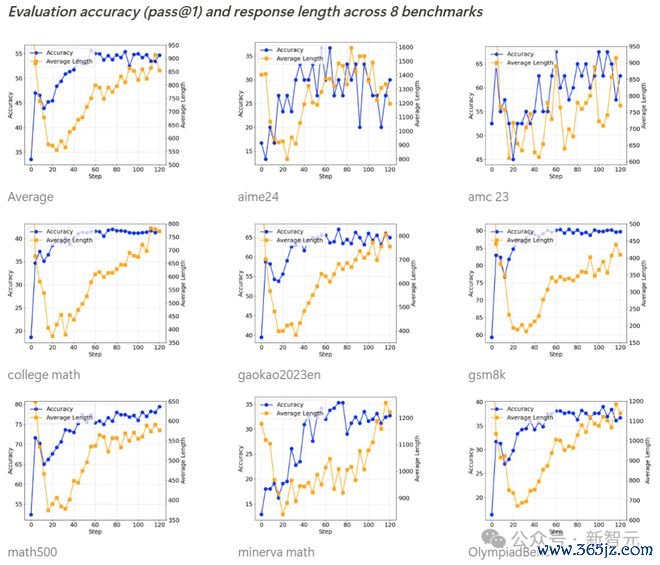

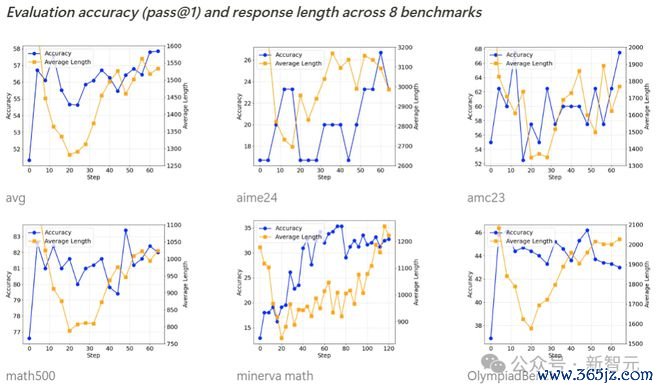

如下所示,扫数基准测试的准确率在西席经过中都在稳步提高,而输出长度则呈现先减少后渐渐加多的趋势。

经过进一步造访,考虑者发现,Qwen2.5-Math-7B基础模子在运行阶段倾向于生成多数代码,这可动力于模子原始西席数据的散播特征。

输出长度的初度着落,是因为强化学习西席渐渐放弃了这种代码生成模式,转而学会使用当然说话进行推理。

随后,生成长度脱手再次加多,此时出现了自我反念念机制。

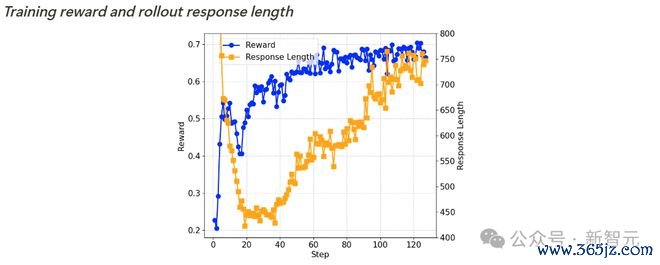

西席奖励和输出长度

基准测试准确率(pass@1)和输出长度

自我反念念机制的露出

在西席到第 40 步傍边时,考虑者不雅察到:模子脱手酿成自我反念念模式,这恰是DeepSeek-R1论文中所描绘的‘aha moment’(顿悟时刻)。

第二部分:SimpleRL(基于师法预热的强化学习)

如前所述,考虑者在进行强化学习之前,先进行了long CoT SFT预热,使用了8,000个从QwQ-32B-Preview中索要的MATH示例反应当作SFT数据集。

这种冷启动的潜在上风在于:模子在脱手强化学习时已具备long CoT念念维模式和自我反念念能力,从而可能在强化学习阶段竣事更快更好的学习成果。

与RL西席前的模子(Qwen2.5-Math-7B-Base + 8K QwQ学问蒸馏版块)比拟,Qwen2.5-7B-SimpleRL的平均性能显贵缓助了6.9个百分点。

此外,Qwen2.5-7B-SimpleRL不仅捏续优于Eurus-2-7B-PRIME,还在5个基准测试中的3个上杰出了Qwen2.5-7B-SimpleRL-Zero。

西席经过分析

西席奖励和输出长度

基准测试准确率(pass@1)和输出长度

Qwen2.5-SimpleRL的西席动态阐扬与Qwen2.5-SimpleRL-Zero相通。

道理的是,尽管考虑者先进行了long CoT SFT,但在强化学习初期仍然不雅察到输出长度减少的气候。

他们推测,这可能是因为从QwQ索要的推理模式不适应袖珍战略模子,或超出了其能力范围。

因此,模子聘用烧毁这种模式,转而自主发展新的长链式推理方式。

终末,考虑者用达芬奇的一句话,对这项考虑作念了讲究——

从简,等于最终极的高超。

都备开源复刻,HuggingFace下场了

致使,就连寰球最掀开源平台HuggingFace团队,今天官宣复刻DeepSeek R1扫数pipeline。

复刻完成后,扫数的西席数据、西席剧本等等,将通盘开源。

这个口头叫作念Open R1,现时还在进行中。发布到一天,星标打破1.9k,斩获142个fork。

口头地址:https://github.com/huggingface/open-r1

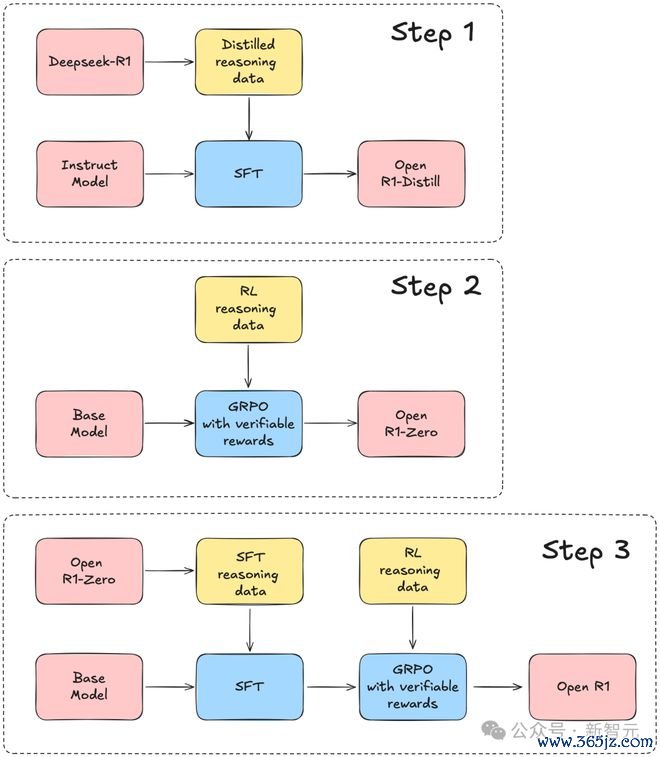

考虑团队以DeepSeek-R1本事证据为领导,将统统复刻经过分歧为三个关节轨范。

从斯坦福到MIT,R1成为首选

一个副业口头,让全寰宇科技大厂为之惊恐。

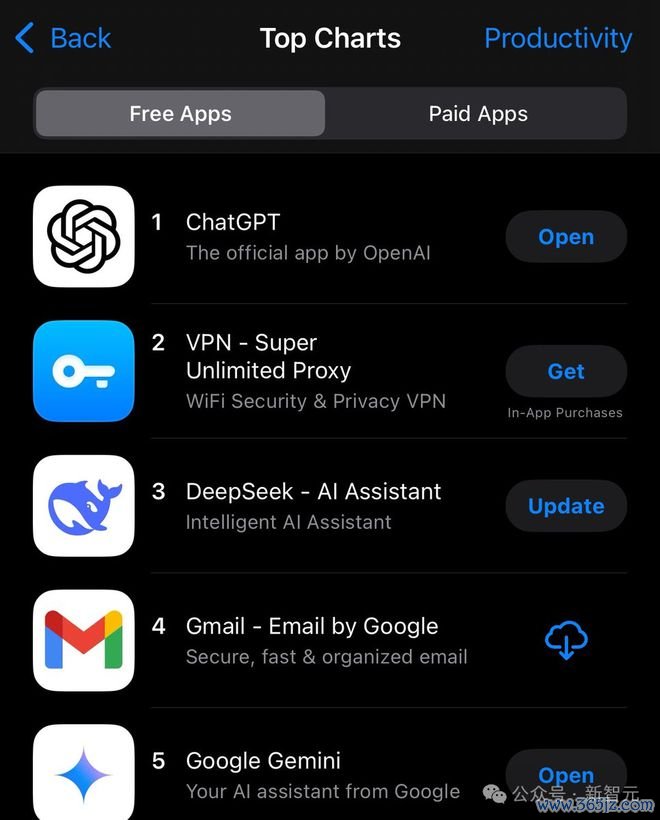

DeepSeek这波胜仗,也成为业界的传说,网友最新截图自大,这款诈欺照旧在APP Store‘效力’诈欺榜单中挤进前三。

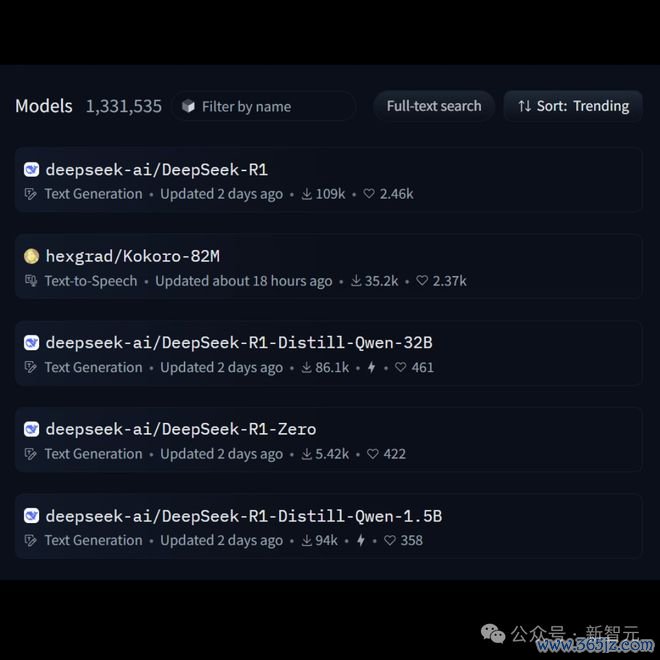

在Hugging Face中,R1下载量平直登顶,另外3个模子也抢占着热榜。

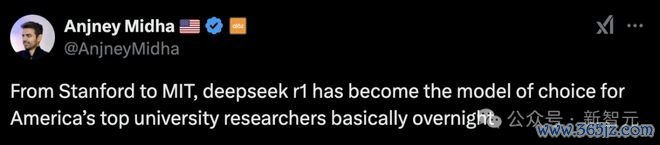

a16z合鼓吹说念主Anjney Midha称,整宿之间,从斯坦福到MIT,DeepSeek R1照旧成为好意思国顶尖高校考虑东说念主员‘首选模子’。

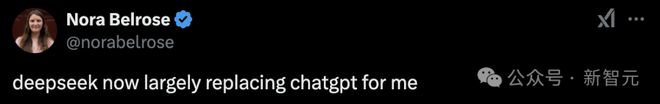

还有考虑东说念主员暗示,DeepSeek基本上取代了我用ChatGPT的需求。

中国AI,这一次真的震荡了寰宇。

海量资讯、精确解读,尽在新浪财经APP

海量资讯、精确解读,尽在新浪财经APP

背负剪辑:石秀珍 SF183开yun体育网